by Abhas Ricky、 Nashua Springberry

この記事は、2023/12/20 に公開された「Announcing Cloudera’s Enterprise Artificial Intelligence Partnership Ecosystem」の翻訳です。

Cloudera は新たに、エンタープライズ向け人工知能 (AI) エコシステムを構築するためにパートナーシップを立ち上げ、AI ソリューションを推進しています。企業は AI ソリューションが競争市場において重要な差別化要因であると認識しています。そして、業務の合理化、顧客体験の向上、売り上げ増加のために、大きな投資を行う体制を整えています。だからこそ Cloudera は、お客様が AI から得られる価値を最大化するために、AI をより簡単に、より経済的に、より安全にするテクノロジープロバイダーのエコシステムを構築しています。

最近、ニューヨークで開催された Evolve カンファレンスにて、アマゾン ウェブ サービス (AWS)、NVIDIA、および Pinecone を、初期AI エコシステム パートナーとして発表できたことを非常にうれしく思います。

これらの初期パートナーに加えて、主要な AI コミュニティおよびモデルハブである Hugging Face、および AI ワークロード向けのクラス最高のコンピューティングフレームワークである Ray をエコシステムアクセラレータとして迎えています。

今回のブログでは、これらの新規もしくは、さらに強化されたパートナーシップの概要と、それらが AI アプリケーションのライフサイクルをサポートする新たな AI テクノロジースタックにどのように適合するのかご説明します。

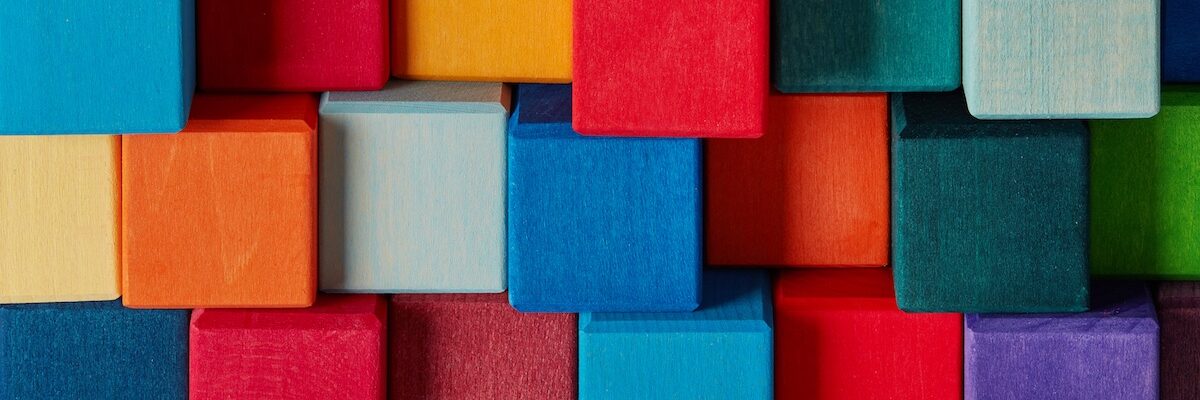

まずはエンタープライズ AI スタックから始めたいと思います。チャットボットのような AI アプリケーションは、クローズドソースもしくはオープンソースの基盤モデルの上に構築されています。これらのモデルは、データ管理プラットフォームからのデータで、学習または補強されます。データ管理プラットフォーム、モデル、そしてエンドアプリケーションは、クラウドインフラストラクチャや専用ハードウェアによって駆動されます。Cloudera Data Platform を含むスタックでは、アプリケーションと基礎モデルは Cloudera Machine Learning を介してデータ管理プラットフォームからデプロイすることもできます。

初期エコシステムパートナーとアクセラレータを含む将来のエンタープライズ AI スタックは、次の通りです。

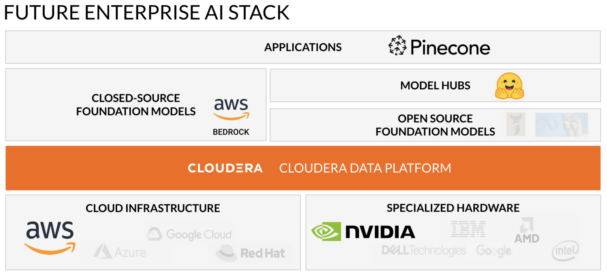

このスタックが、エンタープライズ AI アプリケーションのライフサイクルをサポートするということを表した図は次の通りです。

このエコシステムが AI アプリケーションのライフサイクルをどのようにサポートするか、簡単な例を使って説明したいと思います。

このエコシステムが AI アプリケーションのライフサイクルをどのようにサポートするか、簡単な例を使って説明したいと思います。

- ある企業は、運用コストの削減と顧客体験の向上のために、サポートチャットボットを導入したいと考えている

- Cloudera Machine Learning (CML) を使って、Amazon Bedrock (APIコールでアクセス) またはHugging Face (ダウンロードでアクセス) からジョブに最適な基盤 LLM を選択することができる

- そして、Flask のようなフレームワークを使って CML 上にアプリケーションを構築することができる

- 各質問を Pinecone のベクトルデータベースに保存されている埋め込みと照合し、Cloudera Open Data Lakehouse のデータで質問を強化することで、チャットボットの回答の精度を向上させることができる (仕組みについては後述)

- 最後に、NVIDIA GPU や AWS Inferentia を搭載した CML のコンテナ化されたコンピュートセッションを使用してアプリケーションをデプロイすることができる

各パートナーとアクセラレータが Cloudera とどのように協力していくのか、そして、お客様が AI から得られる価値を最大化するために、より簡単で、経済的で、安全な方法を詳しくご紹介します。

AI エコシステムの創設パートナー|NVIDIA、AWS、Pinecone

ハイライト:

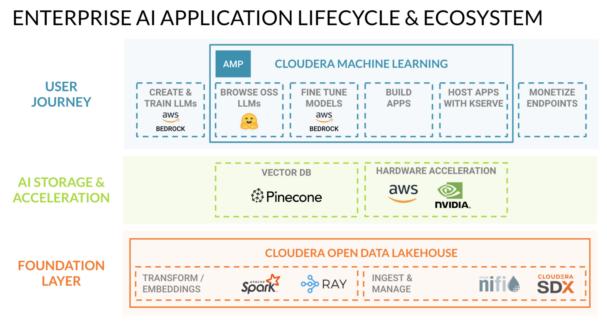

現在、NVIDIA GPU はすでに Cloudera Data Platform (CDP) で利用可能であり、Cloudera の顧客は、データ・エンジニアリング・ワークロードにおいて、最新の CPU のみの代替品と比較して50%未満の追加コストで8倍のパフォーマンスを得られます。この技術協力の新たなフェーズは、以下の分野で、AIアプリケーションのライフサイクル全体にわたって重要な機能を追加することで、その成功を基礎として構築されています。

- NVIDIA GPU を使用して、Cloudera on Public Cloudおよびオンプレミスで、AI および機械学習ワークロードを高速化

- Cloudera Private Cloud の GPU でデータパイプラインを高速化

- NVIDIA Triton Inference Server を使用した CML でのAIモデルの展開

- NVIDIA NeMo を使用した CML における生成AIモデルの高速化

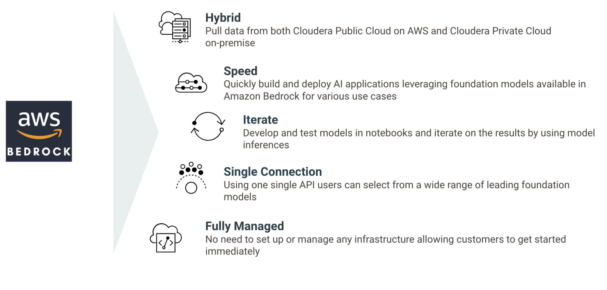

ハイライト:

フルマネージド・サーバーレス・サービスである Amazon Bedrock を活用して、Cloudera は生成 AI 機能を構築しています。顧客は、Cloudera で利用可能なこれらの新機能を使用して、生成 AI アプリケーションを迅速かつ容易に構築することができます。

Amazon Bedrock の一般提供開始に伴い、Cloudera は Cloudera Machine Learning で構築された最新の応用MLプロトタイプ (Amazon Bedrock を使用して構築された CML テキスト要約 AMP) をリリースしました。この AMP を使用すると、Amazon Bedrock で利用可能な基盤モデルを使用して、Cloudera Public Cloud on AWS と Cloudera Private Cloud オンプレミスの両方で管理されるデータのテキスト要約を行うことができます。詳細はこちらのブログ記事をご覧ください。

Cloudera は、AWS Inferentia と AWS Trainium を搭載した Amazon EC2 インスタンスを、 Cloudera Machine Learning サービス (CML) に統合する作業を行っています。これにより、CML の顧客は、AIワークロード専用に構築された強力で効率的なアクセラレータを使用して、分離されたコンピュートセッションをスピンアップできるようになります。詳細は こちらのブログ記事をご覧ください。

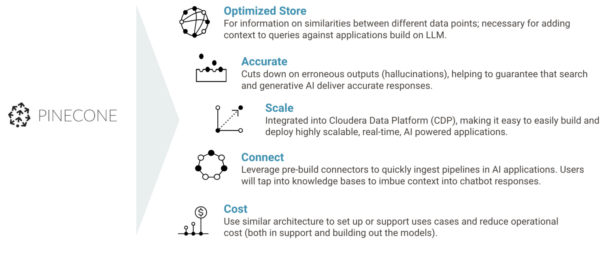

ハイライト:

この提携により、Cloudera は Pinecone のクラス最高のベクターデータベースを Cloudera Data Platform (CDP) に統合でき、企業は Cloudera 上で高度にスケーラブルかつリアルタイムな AI 搭載アプリケーションを、容易に構築・展開できるようになります。

これには、開発者が自分のウェブサイトのデータから新規ナレッジベースを素早く作成・拡張できるようにする新しいAMPのリリースが含まれます。顧客がAIアプリケーションでインジェストパイプラインを素早くセットアップできるようにする事前構築済みのコネクターも同様です。

AMP では、Pinceone のベクトル データベースがこれらのナレッジ ベースを使用してチャットボットの応答にコンテキストを埋め込み、有用な出力を保証します。この AMP の詳細と、ベクターデータベースが AI アプリケーションにどのようにコンテキストを追加するかについては、こちらのブログ記事をご覧ください。

AI エコシステムの加速|Hugging Face、Ray:

ハイライト:

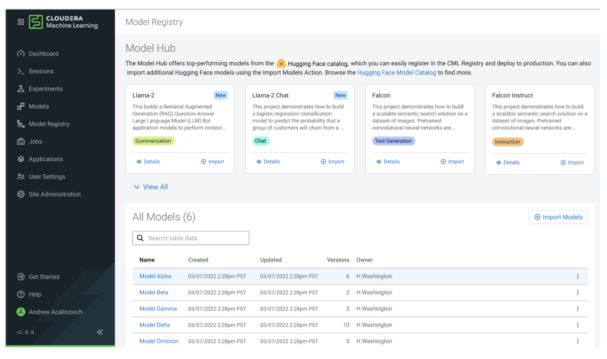

Cloudera が、Hugging Face の市場をリードする LLM、生成 AI、および従来の事前訓練された機械学習モデルとデータセットを Cloudera Data Platform に統合することで、お客様が AI アプリケーションを展開する際の価値実現までの時間を大幅に短縮できるようにします。Cloudera と Hugging Face は、3つの主要な統合によってこれを実現する計画です。

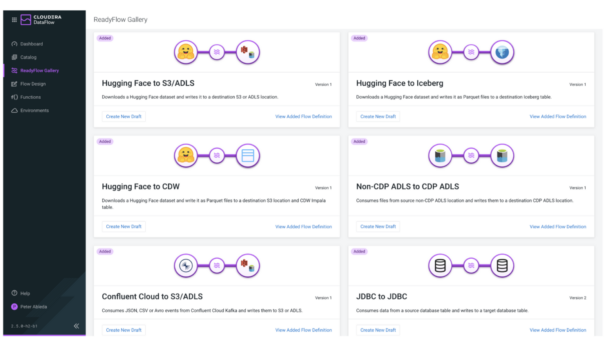

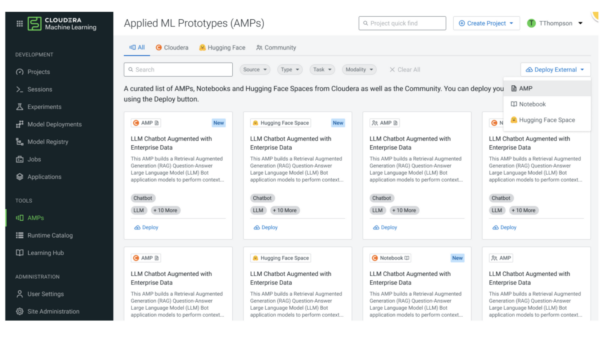

Hugging Face の統合:Cloudera Machine Learning (CML) から Hugging Face のモデルをワンクリックでインポートし、デプロイします。

Hugging Face セットの統合:事前に構築された Cloudera Data Flow ReadyFlow を介して、 Hugging Face のデータセットを Cloudera Data Warehouse (CDW) の Iceberg テーブルにワンクリックでインポートできます。

Hugging Face スペースの統合:Hugging Face の Spaces(小規模MLデモ用の構築済みウェブアプリケーション)を Cloudera Machine Learning 経由でインポートし、ワンクリックでデプロイできます。これらは、Hugging Face の LLM を使用して開発された LLM チャットボットなど、開発者が、事前に構築された AI アプリケーションを素早く立ち上げることを可能にする CML のAMPのカタログを補完するものです。

GPT のような LLM や、ChatGPT のような生成 AI の訓練や微調整には、膨大な計算が必要である点は、OpenAI の話題の中で忘れられがちです。繰り返しの度に、より多くの計算が必要となり、ムーアの法則による制限によって、そのタスクはシングル・コンピュート・インスタンスから分散コンピュートへと急速に移行します。これを達成するために、OpenAI は GPT モデルの各リリースを訓練する分散コンピューティングプラットフォームに、Ray を採用しています。Rayは、分散AIコンピュートワークロードにおいて Apache Spark よりも優れたパフォーマンスを発揮することから、人気のフレームワークとして台頭してきました。

Rayは、Cloudera Machine Learning のオープン・バイ・デザイン・アーキテクチャで使用することができ、CDP に高速分散AIコンピューティングをもたらします。これは、Clouderaが公開している cml エクステンションのPython パッケージの Ray モジュールによって可能です。Ray の詳細と Cloudera Machine Learning への導入方法については、こちらのブログ記事をご覧ください。